億道研究院與 IDEA 研究院聯(lián)手打造端到端語(yǔ)音大模型UniTTS,助力端側(cè)人機(jī)交互發(fā)展

在當(dāng)今數(shù)字化時(shí)代,人機(jī)交互已成為人們生活中不可或缺的一部分。從智能手機(jī)上的語(yǔ)音助手到智能家居設(shè)備的語(yǔ)音控制,人機(jī)語(yǔ)音交互技術(shù)正以驚人的速度改變著我們的生活方式。然而,要實(shí)現(xiàn)真正自然、流暢且富有情感的人機(jī)語(yǔ)音交互,依然面臨諸多挑戰(zhàn)。傳統(tǒng)語(yǔ)音交互系統(tǒng)在處理音頻信息時(shí),難以充分捕捉和利用音頻中的副語(yǔ)言特征,比如音色、韻律和情感等,這使得由機(jī)器生成的語(yǔ)音在自然度和情感表達(dá)方面存在不足。此外,隨著人工智能技術(shù)的不斷發(fā)展,人們對(duì)語(yǔ)音交互系統(tǒng)的要求也越來(lái)越高,不僅希望它能準(zhǔn)確理解并執(zhí)行指令,更期望它能像人類(lèi)一樣,通過(guò)語(yǔ)音傳遞情感和個(gè)性。

為了突破這些限制,實(shí)現(xiàn)更加自然、智能的端側(cè)人機(jī)語(yǔ)音交互體驗(yàn),億道研究院與粵港澳大灣區(qū)數(shù)字經(jīng)濟(jì)研究(IDEA研究院)聯(lián)合實(shí)驗(yàn)室(COTLab)共同致力于語(yǔ)音大模型的研發(fā),打造了端到端語(yǔ)音大模型 UniTTS系列。

簡(jiǎn)介

當(dāng)前,基于離散編碼的LLM-based的建模方案是TTS主流方法之一,而音頻離散編碼方案會(huì)嚴(yán)重影響模型最終效果。目前,部分研究者將聲學(xué)特征和語(yǔ)義特征分開(kāi)提取,但并不是所有的speech信息都適合被分解為語(yǔ)義和聲學(xué)信息,例如speech中的笑聲、哭聲等強(qiáng)情感表征的部分,以及具有豐富背景音或者音效的高質(zhì)量universal audio數(shù)據(jù)。部分研究者采用了GRFVQ-based多碼本方案,在提升其性能的同時(shí),也使得語(yǔ)音離散化序列的比特率急速提升,導(dǎo)致語(yǔ)音序列過(guò)長(zhǎng),使得LLMs建模語(yǔ)音序列關(guān)系的難度大增,因此低碼率也是此方案關(guān)注的一個(gè)重要指標(biāo)。本工作提出了DistilCodec和UniTTS,DistilCodec是訓(xùn)練得到的單碼本,碼本利用率接近100%且碼本利用均勻,并基于DistilCodec做音頻離散化,主干網(wǎng)絡(luò)使用qwen2.5-7B,訓(xùn)練得到UniTTS模型。具體工作貢獻(xiàn)如下:

(1)采用多碼本教師模型(GRVQ)蒸餾到單碼本的學(xué)生模型(DistilCodec),達(dá)到近100%的碼本利用率,實(shí)現(xiàn)了簡(jiǎn)潔、高效的音頻離散編解碼,可為音頻大模型提供無(wú)需解耦的聲學(xué)和語(yǔ)義音頻壓縮表征。

(2)本工作提出了UniTTS,其基于DistilCodec完整Audio特征建模的能力,具備完整語(yǔ)音End2End的輸入輸出能力,UniTTS生成的音頻具備更自然的情感表現(xiàn)力。

(3)本工作提出了Audio Language Model新的訓(xùn)練范式:DistilCodec的訓(xùn)練稱(chēng)為音頻感知建模,其只專(zhuān)注于音頻的特征離散化,使用Universal audio的數(shù)據(jù)提升其魯棒性。UniTTS的訓(xùn)練稱(chēng)為音頻認(rèn)知建模,其分為pretrain、SFT、Alignment三階段,在pretrain階段,借助DistilCodec的完整音頻特征建模能力,加入了universal audio模態(tài)自回歸任務(wù),并驗(yàn)證了其有效性;UniTTS具備接收任意形式的text-audio interleaved prompt,所以在SFT階段詳細(xì)驗(yàn)證了不同prompt對(duì)于TTS性能的影響;由于UniTTS語(yǔ)音模態(tài)以完全End2End的形式加入到了LLM中,所以使用直接偏好優(yōu)化,進(jìn)一步提升語(yǔ)音生成能力。

UniTTS & DistilCodec UniTTS架構(gòu)

UnitTTS架構(gòu)

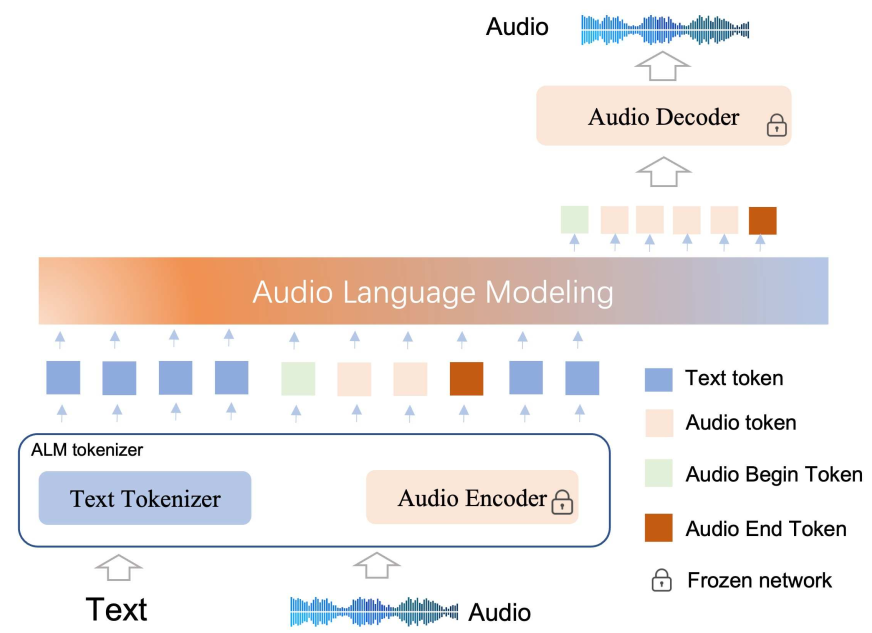

UniTTS架構(gòu)主要包括ALM Tokenizer,Backbone(Transformer)兩個(gè)部分。ALM Tokenizer分為T(mén)ext Tokenizer和Audio Encoder,Text Tokenizer完成文本的分詞,Audio Encoder完成音頻的分詞和重構(gòu)。Backbone基于Transformer架構(gòu)實(shí)現(xiàn)兩種模態(tài)token的交替自回歸。

模型架構(gòu)使用一個(gè)單碼本tokenizer和一個(gè)decoder-only模型。為了將音頻離散化為token,并用大模型建模token之間的關(guān)系,首先訓(xùn)練了一個(gè)碼本利用率接近100%單碼本codec(DistilCodec),主干網(wǎng)絡(luò)使用qwen2.5-7B模型,在模型原來(lái)的詞表后新增32K音頻token,因此擴(kuò)充后的詞表共計(jì)180k。模型訓(xùn)練主要分成兩個(gè)部分,音頻感知建模以及音頻認(rèn)知建模,其中音頻模態(tài)感知建模過(guò)程不進(jìn)行語(yǔ)義對(duì)齊,專(zhuān)注于音頻特征的離散化以及音頻重建;在音頻模態(tài)認(rèn)知建模過(guò)程中,在已有語(yǔ)言模型的基礎(chǔ)上,將音頻模態(tài)和文本模態(tài)進(jìn)行融合,實(shí)現(xiàn)音頻的認(rèn)知建模。

DistilCodec結(jié)構(gòu)

DistilCodec網(wǎng)絡(luò)結(jié)構(gòu)

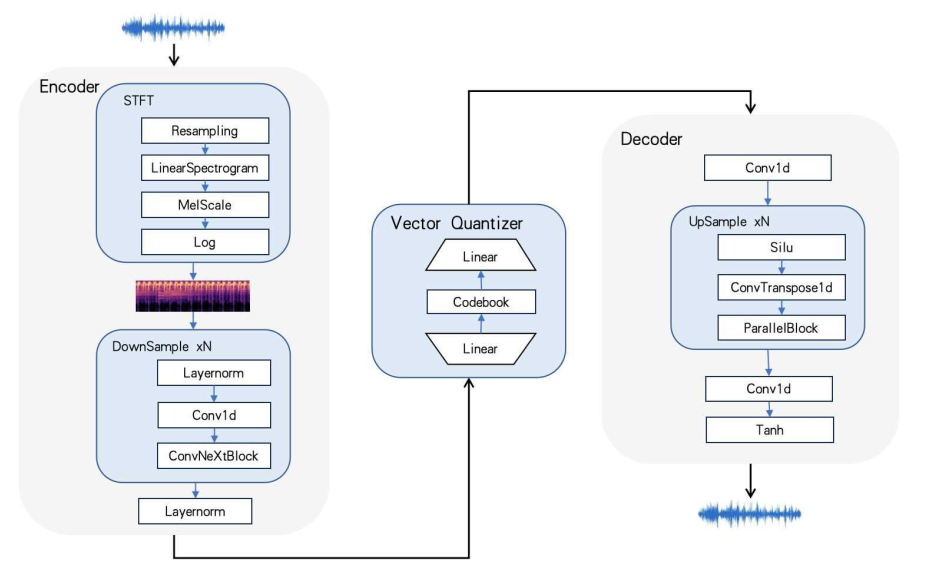

DistilCodec網(wǎng)絡(luò)結(jié)構(gòu)如上,通過(guò)傅立葉變換將音頻轉(zhuǎn)為頻譜,并由堆疊的殘差卷積層實(shí)現(xiàn)特征壓縮,在量化器(Quantizer)中通過(guò)線性層將壓縮特征投影到碼本向量鄰域,其對(duì)應(yīng)鄰域中心的索引作為該音頻片段的離散表征。在反向重構(gòu)過(guò)程中,通過(guò)GAN網(wǎng)絡(luò)重構(gòu)為對(duì)應(yīng)音頻片段。

DistilCodec訓(xùn)練

DistilCodec訓(xùn)練過(guò)程

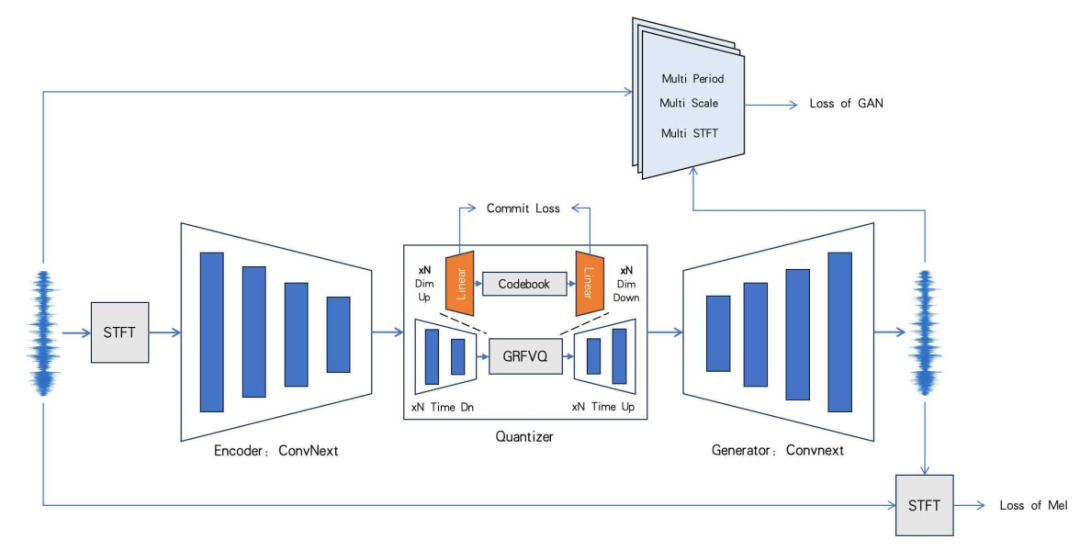

上圖展示了DistilCodec的訓(xùn)練過(guò)程。為了實(shí)現(xiàn)單一超大Codebook的Codec訓(xùn)練,首先通過(guò)使用GVQ、RVQ及FVQ結(jié)合的方式,訓(xùn)練了一個(gè)擁有32個(gè)Codebook的Teacher Codec,然后使用Teacher Codec的Audio-Encoder和Audio-Decoder的參數(shù)初始化一個(gè)Student Codec,此Codec是一個(gè)Residual和Group均為1的單一碼本,但是其Codebook的碼本大小是Teacher Codec的總和。

UniTTS預(yù)訓(xùn)練(Pretrain)

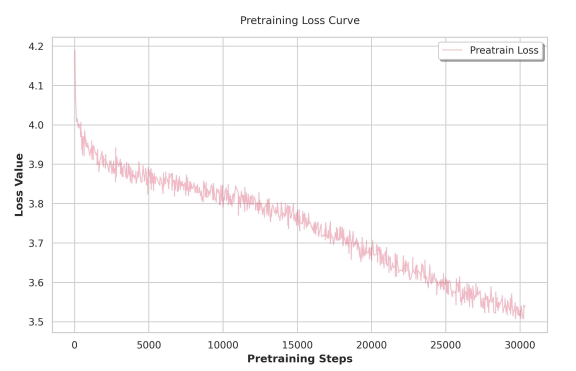

相較于文本建模,音頻建模具有更大的表示空間。因此,大規(guī)模高質(zhì)量文本-音頻配對(duì)數(shù)據(jù)是實(shí)現(xiàn)通用音頻自回歸的前提。UniTTS設(shè)計(jì)了一套多階段的預(yù)訓(xùn)練方法。在第一階段:在預(yù)訓(xùn)練的文本模型基礎(chǔ)上,使模型在文本數(shù)據(jù)、通用音頻數(shù)據(jù)和一定數(shù)量的文本-音頻配對(duì)數(shù)據(jù)上進(jìn)一步訓(xùn)練,使模型學(xué)習(xí)音頻建模。然而,將音頻訓(xùn)練數(shù)據(jù)直接引入預(yù)訓(xùn)練的文本模型,會(huì)導(dǎo)致模態(tài)競(jìng)爭(zhēng),模型的文本生成能力退化。為此,在第二階段:結(jié)合基于文本的指令數(shù)據(jù)集,以及現(xiàn)有的通用音頻和文本-音頻配對(duì)數(shù)據(jù)集,進(jìn)一步增強(qiáng)模型的文本生成能力。此外,為了適應(yīng)更長(zhǎng)的上下文序列,音頻訓(xùn)練要求將模型的上下文窗口大小,從8,192擴(kuò)展到16,384,以適應(yīng)具有長(zhǎng)序列特性的音頻模態(tài)數(shù)據(jù)。

預(yù)訓(xùn)練損失曲線

UniTTS指令微調(diào)(SFT)

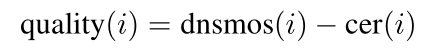

在監(jiān)督微調(diào)過(guò)程中,數(shù)據(jù)質(zhì)量將顯著影響模型最終的能力。現(xiàn)有開(kāi)源文本-音頻配對(duì)數(shù)據(jù)集有一定缺陷,例如:1)參考文本通常來(lái)自ASR標(biāo)注,固有地包含噪聲 2)大量樣本取自于有聲書(shū)籍、博客等來(lái)源,往往包含較長(zhǎng)的沉默片段。這會(huì)TTS模型的生成效果。為此,UniTTS 設(shè)計(jì)了一種實(shí)用的復(fù)合質(zhì)量評(píng)分方法過(guò)濾樣本:

其中,dnsmos有效地過(guò)濾音頻聲學(xué)質(zhì)量,CER表示為重標(biāo)注的錯(cuò)字率,可進(jìn)一步過(guò)濾標(biāo)注錯(cuò)誤。基于Quality的重排和閾值篩選,可有效優(yōu)化訓(xùn)練樣本的質(zhì)量。

UniTTS偏好對(duì)齊(Alignment)

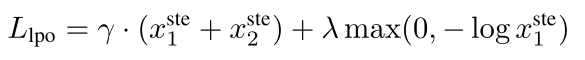

SFT可使模型有效學(xué)習(xí)特定語(yǔ)音任務(wù)的模式,但一定程度上會(huì)產(chǎn)生韻律延長(zhǎng)、重復(fù)的問(wèn)題(類(lèi)似文本域的復(fù)讀現(xiàn)象)。為此,UniTTS采用直接偏好優(yōu)化(DPO)進(jìn)一步優(yōu)化模型效果,但對(duì)于長(zhǎng)序列音頻建模而言,DPO容易出現(xiàn)模式崩潰。因此,UniTTS引入線性偏好優(yōu)化方法(LPO)作為DPO的替代方案:

在LPO損失中,x1、x2分別為正、負(fù)樣本采樣策略偏好,通過(guò)抑制正負(fù)樣本的直通策略估計(jì),并小幅促進(jìn)正樣本策略以修正模型策略梯度方向,穩(wěn)定長(zhǎng)序列偏好優(yōu)化訓(xùn)練。

實(shí)驗(yàn)結(jié)果

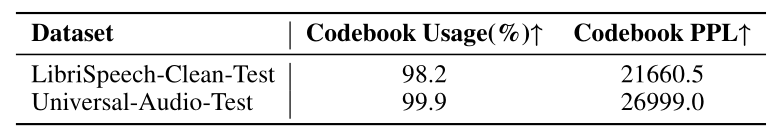

在實(shí)驗(yàn)部分,采用LibriSpeech-Clean數(shù)據(jù)集和自建Universal Audio數(shù)據(jù)集來(lái)評(píng)估DistilCodec的困惑度(PPL)和碼本利用率(Usage),相應(yīng)的實(shí)驗(yàn)結(jié)果如下。在語(yǔ)音和通用音頻數(shù)據(jù)集上,DistilCodec實(shí)現(xiàn)了近乎最佳的碼本利用率(接近100%)。實(shí)驗(yàn)中,我們還使用LibriSpeech-Clean-Test Benchmark對(duì)DistilCodec的語(yǔ)音重建能力進(jìn)行了全面的對(duì)比分析。

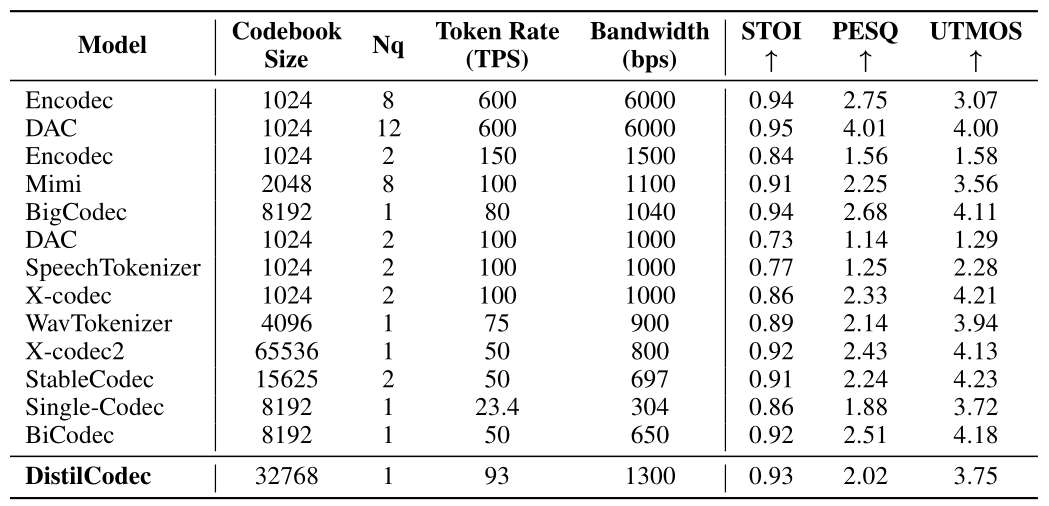

從下表中可以看到,DistilCodec的碼本利用率接近100%,同時(shí)碼本利用均衡,因此DistilCodec對(duì)于語(yǔ)音的離散化具備一定的性能。

碼本率用率和困惑度對(duì)比

在LibriSpeech的Clean和Other數(shù)據(jù)集,進(jìn)行評(píng)估,DistilCodec在1KBPS左右的codec下,STOI指標(biāo)達(dá)到了SOTA,詳細(xì)指標(biāo)如下表所示。

不同Codec模型綜合對(duì)比

為了進(jìn)行嚴(yán)格的評(píng)估,我們也將UniTTS與現(xiàn)有方法進(jìn)行對(duì)比,主要包括:CosyVoice2、Spark-TTS、LLaSA、F5-TTS Fish-Speech、IndexTTS。結(jié)果表明,與UniTTS-SFT相比,UniTTS-LPO在情感表現(xiàn)力、保真度和自然度方面取得了全面的進(jìn)步,驗(yàn)證了LPO訓(xùn)練方法的有效性。UniTTS-LPO的性能提升,主要源于由蒸餾解碼驅(qū)動(dòng)的韻律-音色-情感特征的整體建模,以及多樣化的無(wú)監(jiān)督訓(xùn)練。

結(jié)語(yǔ)

通過(guò)高效的離散編解碼技術(shù),DistilCodec實(shí)現(xiàn)在單碼本場(chǎng)景下利用率接近100%,并且碼本利用均勻,有效地拓展了音頻大模型在多種音頻任務(wù)上的應(yīng)用潛力,為不同音頻場(chǎng)景下的適應(yīng)性奠定了基礎(chǔ)。UniTTS采用三階段訓(xùn)練策略,實(shí)現(xiàn)穩(wěn)定的大模型跨模態(tài)訓(xùn)練。在人機(jī)交互的背景下,UniTTS不僅提升了語(yǔ)音交互的自然度和流暢性,為用戶帶來(lái)了更富有情感和個(gè)性的交互體驗(yàn)。

0人